IEG: Robust Neural Network Training to Tackle Severe Label Noise

- authors: Zizhao Zhang, Han Zhang, Sercan Ö. Arık, Honglak Lee, Tomas Pfister (Google AI)

Three Key Insights

- Isolation of noisy labels;

- Escalation of useful supervision from mislabeled data;

- Guidance from small trusted data (2‰ trusted data).

两个问题

- 半监督训练中是否有必要抛弃具有噪声标签的数据?

- 如何从噪声标签个中提取有效信息?

创新点

- A meta learning based re-weighting and re-labeling

- Label estimation

- Unsupervised regularization

Methods

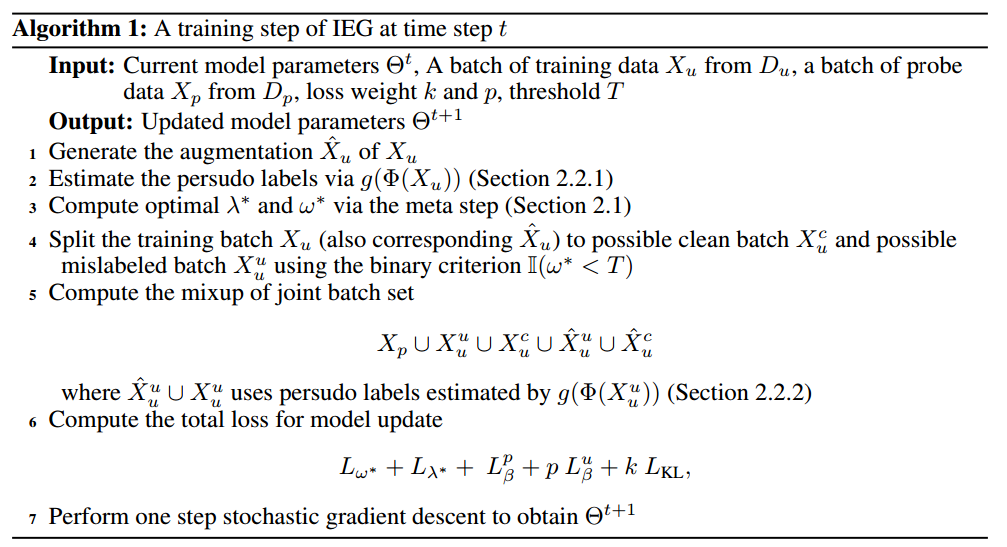

算法流程:

Meta Optimization-based Reweighting and Relabelling

记:

有噪数据 (Noised Data): $D_u={(x_i, y_i), 1<i<N}$

引子数据 (Probe Data): $D_p={(x_i, y_i), 1<i<M}$

目标神经网络定义为 $\Phi\left(x_{i}; \Theta\right)$, 且 $\Theta$ 是 $\omega$ 的函数.

若将 $\omega$ 当成是可学习的参数, 则 Meta-step 步骤可以看成是利用 probe 寻找 $\omega$ 的最优参数, 该 $\omega$ 需满足在 $D_p$ 上具有最优性能. 这里如何构造 probe data 显得尤为重要 .

求解 $t$ 步的 $\omega$ 即为优化如下损失函数.

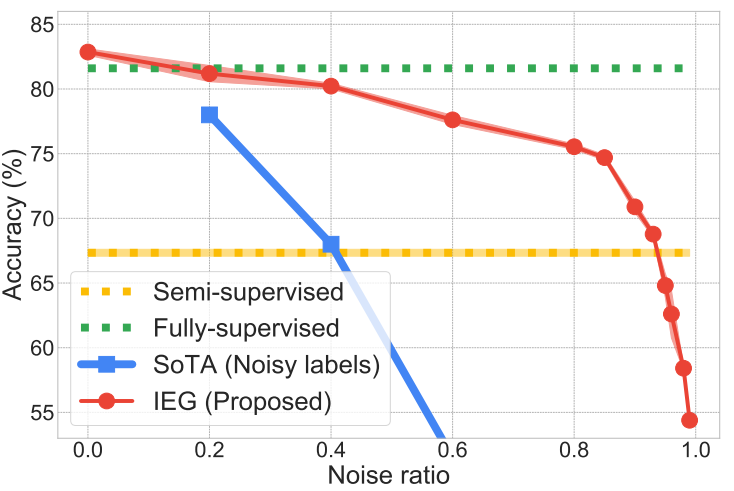

最优的 $\omega^*$ 理论上对误标数据的权重分配为 0.

随着噪声数据比例上升, 大部分数据将会被抛弃. 为了改善信息丢失的问题, 作者提出了伪标签策略. 记伪标签函数估计器为 $g(\Phi(\Theta))$, 那么整合后的目标函数为

优化后的 re-labelling 控制器 $\lambda_t^*$ 通过梯度的符号函数进行更新:

使用梯度的符号函数 $|\nabla \lambda|$ 代替 $\lambda_0 - \nabla \lambda$ 进行更新的原因有二: (1) 当伪标签十分接近真实标签时, $|\nabla \lambda|$ 将会非常小; (2) simply averaging $y_i$ and $g(\Phi(x_i))$ using scalar $\lambda^*$ makes resulting pseudo label distribution less sharp.

误标数据标记伪标签

Pseudo Labels

在给定权重 $\omega$ 条件下, 算法通过设定二分类准则 ($\omega_i < T$) 将数据划分为 possibly-mislabeled 和 possibly-clean 两类样本. 作者采用半监督学习方法 MixMatch 计算 $g(\Phi(x_i, \Theta))$, 得到 $g_{i}(\Phi(x))=P r_{i}^{\frac{1}{\tau}} / \sum_{i} P r_{i}^{\frac{1}{\tau}}$, 其中 $ Pr= \frac{1}{K}\left(\Phi(x)+\sum_{k}^{K-1} \Phi\left(\hat{x}_{k}\right)\right)$.

引子数据正则引导

由于 Probe data 的数据量很小, 在使用时需要防止过拟合. 为此, 作者采用了 $MixUp$ 正则 $ \text{Mix}_\beta (a, b) = \beta a + (1 - \beta) b $.

其中 $\left\{\left(x_{a}, y_{a}\right),\left(x_{b}, y_{b}\right) \in D_{p} \cup \hat{D}_{u} \cup D_{u}\right\} $, $\hat{D}_u$ 是 $D_u$ 的增广副本.

伪标签预测一致性

作者引入 KL 散度鼓励伪标签具有更强的区分性以保证一致性.

Experiments

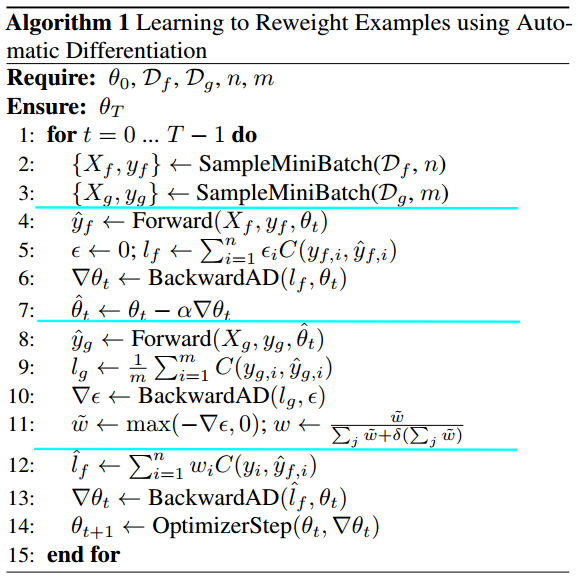

Learning to Reweight Examples for Robust Deep Learning

- authors: Mengye Ren, Wenyuan Zeng, Bin Yang, Raquel Urtasun

- year: 2018

- pubisher: ICML

- codes